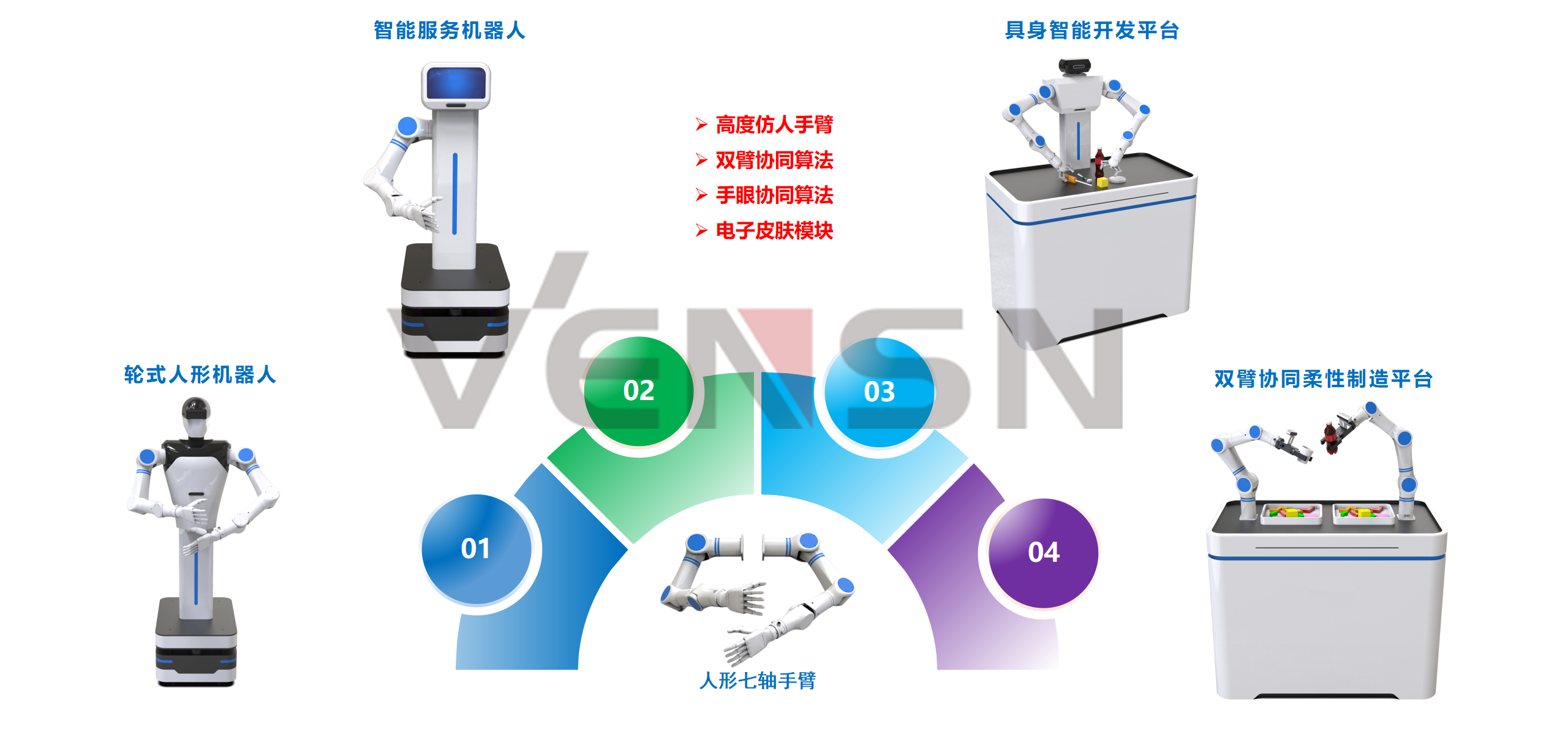

一、产品概述

具身智能作为人工智能技术与机器人技术深度融合的前沿领域,代表了未来智能系统发展的重要方向。本方案中的系列产品,在结构上,主要由机器人(如七轴协作机械臂、移动机器人)、视觉感知系统、语音交互模块、中央运算单元组成。在功能上,通过在中央运算单元内部署如DeepSeek等前沿的大模型技术,以及力控反馈、人机交互等技术,使其能够理解复杂的指令,进行逻辑推理,判断用户的真实意图,从而自主规划并执行相应任务,这也是具身智能机器人与传统机器人的根本区别。

该系列产品,不仅可以满足用户的科研、开发需求,还可以为智能制造、医疗服务和商业服务等场景提供全新的解决方案。

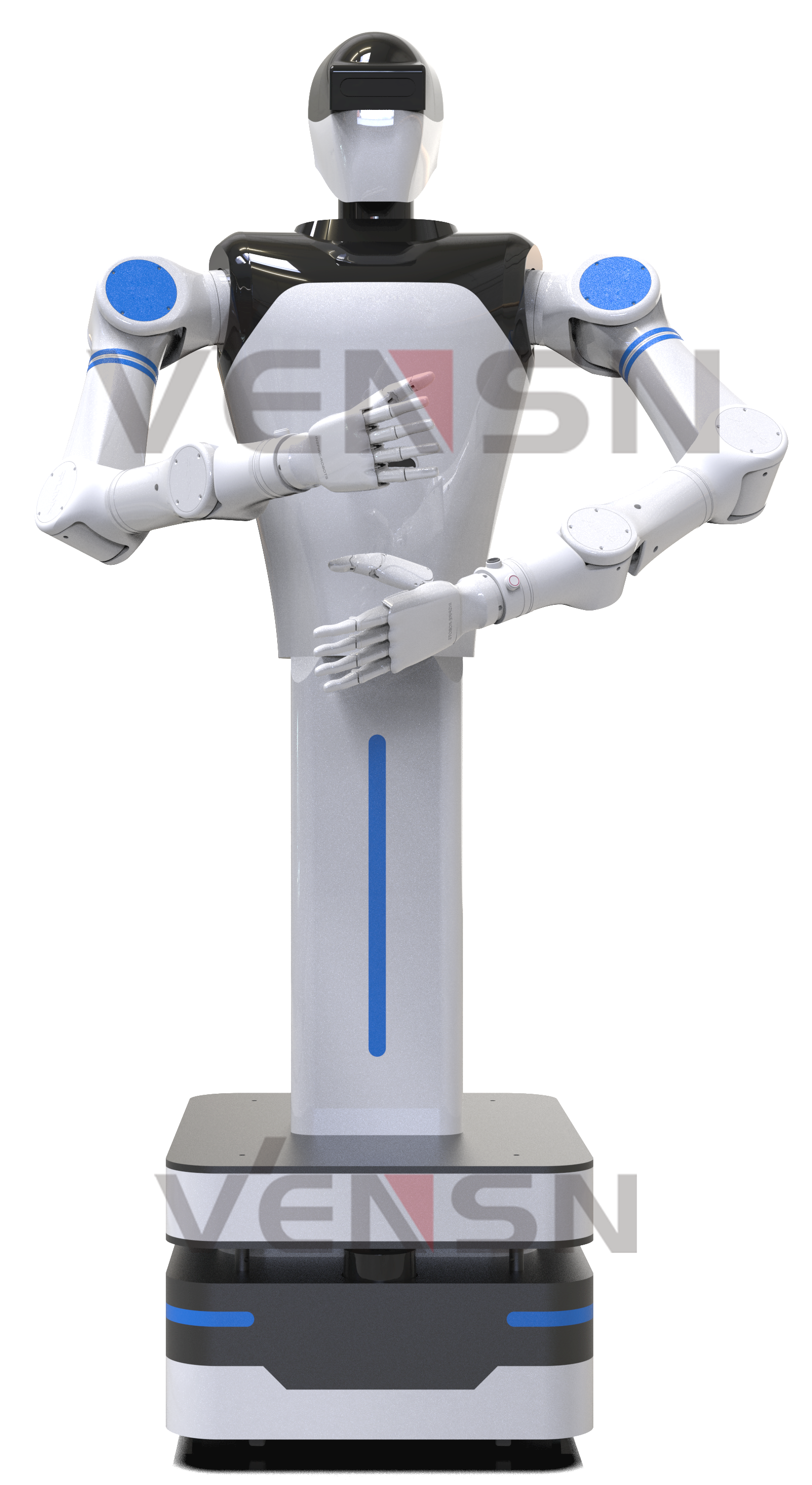

1.轮式人形机器人

人形机器人由仿生双臂系统、多模态感知单元,以及中央运算单元构成,并通过全向移动底盘实现自主导航。在仿生双臂系统中,内置了电子皮肤和力传感器,以便于用户开发基于本体感知的双臂动态防碰撞算法,且双臂采用七自由度仿生关节,能够模拟人类上肢“肩-肘-腕”运动链的灵活性。该双臂构型适用于多类场景应用,比如完成倒水、叠衣服等家庭服务,或从事工业生产、水果采摘等行业应用。总的来说,该产品是一款深度融合仿生学设计、高自由度控制与具身智能技术的先进科研平台,支持面向复杂环境实验、动态环境交互及跨模态人机协作等场景开展研发工作。

2.智能服务机器人

智能服务机器人融合了移动机器人的自主导航能力与七轴人形手臂的高度拟人化能力,可以面向服务场景开展丰富的应用。在结构上,采用中央运算单元进行推理与决策,并通过配备的深度视觉系统、麦克风阵列及激光雷达构成多模态环境感知网络,可以感知人体位置、距离、手势动作、声音特性等多种信息,从而实现与用户的高度自主交互。产品适用于展厅讲解、商超导览、校园接待等应用场景。

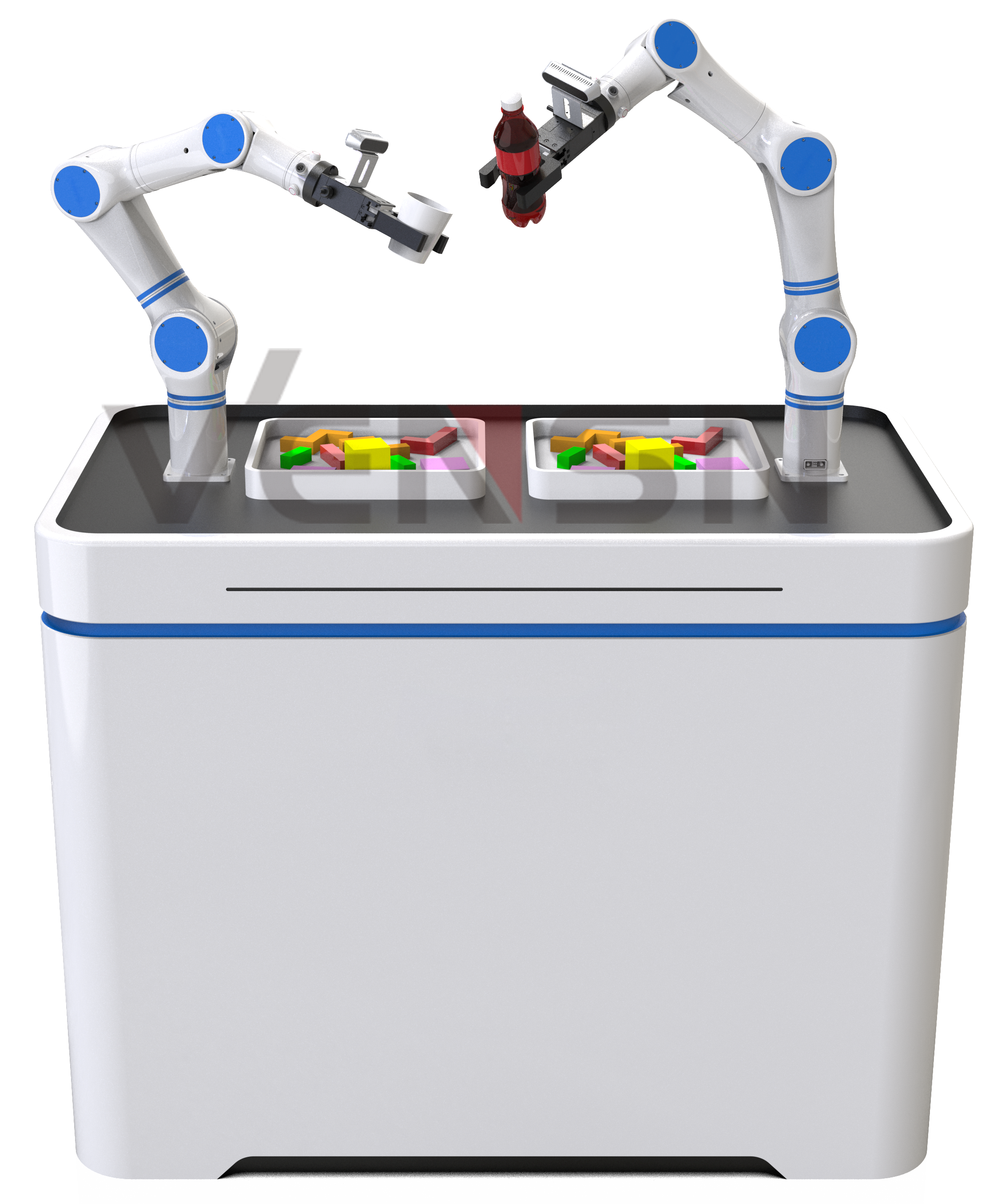

3.双臂协同柔性制造平台

该平台主要面向生产制造场景。通过采用双臂控制系统,以及部署在中央运算单元内的多模态大模型的智能分析能力,实现对复杂作业场景的分析推理与决策,最终精准执行各项任务。在实际操作中,用户可以根据具体需求选择不同类型的末端执行器,比如吸盘、夹爪、灵巧手,结合大模型的学习和推理能力,可以不断优化双臂的运动方式,逐步提升系统的作业效率与准确性。该平台可应用于零部件装配、上下料、良次品分拣等多种柔性制造工序。

4.具身智能开发平台

平台以一台人形机器人的上半身为主体结构,通过将其安装在操作平台上,可以面向生产或生活场景,以高度拟人的形态开展多样化的应用,为具身智能的前沿研究开辟了全新的创新平台。平台通过深度相机实时获取作业区域内的三维信息,结合内置的中央运算单元,以及部署的大模型技术,能够准确识别物体的形状、位置和姿态,从而控制双臂进行高精度的仿人作业。除此之外,该系统还内置强化学习算法,并配置遥操作系统,可用于协同控制算法、多模态感知与决策、自主进化等具身智能领域的先进算法开发与验证。

二、产品功能和特点

1.具身智能与自主决策

本方案的相关产品,均采用自研的七轴人形手臂,通过和视觉、语音、传感器等技术的深度融合,构建了“环境感知-决策-执行”闭环,形成多模态环境感知网络。所有产品均部署大模型技术,可以理解用户的复杂指令,推理出真实意图,并最终做出决策和反馈。例如,在工业分拣场景中,用户可以发出如“把桌上的螺丝刀放到货架上的蓝色盒子里”的语音指令,系统收到该指令后,进行如下推理:抓取目标(螺丝刀)、目标位置(桌上)、放置位置(蓝色盒子)、放置位置坐标(货架),然后,通过视觉系统的协同,自主生成该任务的分步骤指令,准确完成相关任务。同时,在任务执行过程中,可以融合视觉、触觉、位置等环境信息,不断优化任务执行效率。

2.双臂协同控制

双臂系统选用了自研的七轴人形手臂,完全开放底层源代码,支持二次开发,同时具备广泛的运动范围和高度的运动精确度,能够模拟人类手臂的大部分自然动作。

在控制方面,采用了一控二的协同控制系统,即一个控制器控制两台手臂,该方式可以有效的实现双臂协同与冲突规避,同时通过强化学习算法动态分配任务优先级。比如,给机器人规划叠衣服的任务时,系统可以快速给出最优动作规划,还能避免双臂“打架”的情况,配备的电子皮肤则让双臂系统在工作时,及时感知周围环境的变化,结合大模型的决策能力,实时调整运动路径和姿态,实现更加精细的操作。

3.强化学习与自主进化

通过分层强化学习框架与跨场景迁移学习机制,赋予具身智能机器人持续适应复杂环境的能力。比如机器人在执行“帮我拿水过来”这个动作时,用户可以使用强化学习算法训练机器人,将识别任务(寻找水杯)、移动任务(移动到目的地)、抓取任务(采用合适的角度和姿态拿水杯)进行任务分解与策略分层,缩短训练周期。而通过持续学习与环境交互后,机器人则可以动态优化自身行为模型,完成自主进化,快速适应多种复杂应用场景,构建具身智能模型。

强化学习与自主进化的结合将推动人形机器人向“通用智能体”发展,实现完全自主决策。

4.多模态感知与融合

机器人配置了丰富的传感器,如深度视觉、语音识别、激光雷达、超声波测距、电子皮肤、触觉反馈等,构建了一个完善的机器人环境感知系统。在具体应用上,机器人内部安装的语音识别模块,支持声音检测、智能语音识别、声源定位等功能;机器人头部和躯干的的深度视觉系统,可以实现语音、手势、表情、物料、零部件等多种交互信息和产品信息的收集。通过搭载的中央运算单元,机器人在人机交互过程中,可实现自然语言指令解析,从而引导机器人执行指定动作,开展人机协作、语音控制等AI实践。

三、技术架构

具身智能机器人通过多模态感知网络、中央运算单元、双七轴手臂、AI大模型和多类自主学习算法的有机融合,构建了包含“感知-认知-执行-学习”四层架构的智能模型。

1.物理感知层

物理感知层作为具身智能机器人的输入层,通过多模态传感器实时捕捉环境信息,以此来作为机器人进行认知与自主决策的依据。

2.决策认知层

决策认知层依托多模态大模型为具身智能机器人提供全面的感知和认知能力。多模态大模型通过理解和分析物理感知层反馈的视觉、触觉、语音等环境感知数据,推理出类似人类行为的动作模型。

3.行动执行层

行动执行层主要由高自由度的七轴人形手臂和全向活动的移动底盘两部分组成,这些机器人硬件设备能够根据决策认知层下达的子任务指令和各种动作模型,实现如人类活动的各种行动能力。

4.学习反馈层

学习反馈层通过与其他层级之间的协同工作,构建了以强化学习、模仿学习等算法网络为主的优化闭环。通过自主学习的算法网络,具身智能机器人在实际环境中能够不断进行试错和学习,根据环境的反馈信息来调整动作规范,以最大化累积奖励为目标,实现对推理与决策过程的优化和改进。

四、应用方向

1.科研场景人机协作

2.商业服务机器人

3.智慧农业机器人

4.家居服务机器人